新品4U前端I/O NVIDIA HGX™B200 8-GPU系统

发布时间:2025/5/21 8:05:40 访问次数:755

新品4U前端I/O NVIDIA HGX?B200 8-GPU系统的技术分析与应用潜力

随着人工智能和机器学习技术的迅猛发展,计算性能的需求日益增加,特别是在数据中心和高性能计算(HPC)领域。

为了满足这种需求,NVIDIA推出了HGX?B200 8-GPU系统,这一产品的诞生标志着GPU计算技术在性能和灵活性上的又一次飞跃。

HGX?B200系统是一款4U的高密度服务器,专为运行深度学习和大规模计算工作负载而设计。

这种系统能够集成多达八块NVIDIA A100 Tensor Core GPU,每个GPU可以为复杂的计算任务提供强大的并行处理能力。

利用NVIDIA的GPU架构,HGX?B200在处理AI推理、训练和 HPC 工作负载时,都能够提供卓越的性能,其设计本身便是为了最大化数据的吞吐量与处理效率。

在硬件架构方面,HGX?B200采用了最新的第三代NVIDIA NVLink技术,

这一高带宽、低延迟的互连机制使得GPU之间的通信速度大幅提升。通过NVLink的支持,系统内各个GPU之间可以实现高达600 GB/s的带宽,这对于需要处理大量数据的机器学习模型训练至关重要。与此同时,HGX?B200还能够通过NVIDIA的NVSwitch实现多GPU之间的高效流量共享,确保各GPU资源的合理利用,提升整体计算性能。

内存配置方面,HGX?B200提供高达128 GB的GPU内存,每个GPU都能够直接访问这些内存。

这一特性使得系统可以在运行大规模模型时,避免频繁的数据传输,从而降低延迟并提高处理效率。此外,HGX?B200还兼容高速DDR4和DDR5的内存配置,为处理快速增长的计算需求提供了强大的支持。

在网络连接方面,HGX?B200支持100Gb/s以太网和InfiniBand,能够满足大规模数据中心在传输速度和数据吞吐量上的苛刻需求。

尽管在许多高性能计算和深度学习任务中,数据传输的需求往往是性能瓶颈,HGX?B200通过灵活的网络联接方案,确保了数据在各处理器之间的快速流通,从而为实现深度学习和其他计算密集型任务铺平道路。

HGX?B200不仅在硬件性能上表现突出,其软件生态也同样强大。

NVIDIA为HGX?B200提供了一套完整的软件堆栈,包括用于深度学习和高性能计算的CUDA、cuDNN和TensorRT等工具。这些工具不仅使得开发人员能够充分利用GPU的计算能力,还能够简化模型的构建与优化过程。此外,HGX?B200与多种主流的深度学习框架(如TensorFlow、PyTorch等)兼容,使得用户可以轻松地将现有模型迁移到这一平台。

该系统在各类应用领域都展现出极大的潜力。

首先,在人工智能领域,HGX?B200能够加速深度学习模型的训练,特别是在图像识别、自然语言处理和推荐系统等任务中,其强大的并行处理能力使得训练时间显著减少。

其次,在科学计算和模拟领域,HGX?B200可以为物理模拟、化学反应模型以及其他复杂的计算场景提供强有力的支持,推动科学研究的进步。

值得关注的是,HGX?B200的设计还考虑到了能源效率。

相较于传统的计算架构,这一系统能够在提供更高性能的同时,降低功耗。这一特性在如今关注绿色计算的环境中尤为重要,很多数据中心都在寻找方法来提高能效,同时减少运营成本。HGX?B200通过采用先进的散热技术与高效能的冲突管理策略,使得在高负载下依然能保持较低的能耗和温度。

综合来看,NVIDIA HGX?B200 8-GPU系统在性能、灵活性以及能效等方面的多重优势,使其成为高性能计算与人工智能领域的重要选择。这种系统不仅可以支持现有的计算需求,还为未来新兴技术的发展打下了基础。随着AI和大数据的持续发展,HGX?B200所具备的强大算力和高效能,必将推动更多创新的实现与应用的落地,成为助力各行业转型升级的重要动力。

新品4U前端I/O NVIDIA HGX?B200 8-GPU系统的技术分析与应用潜力

随着人工智能和机器学习技术的迅猛发展,计算性能的需求日益增加,特别是在数据中心和高性能计算(HPC)领域。

为了满足这种需求,NVIDIA推出了HGX?B200 8-GPU系统,这一产品的诞生标志着GPU计算技术在性能和灵活性上的又一次飞跃。

HGX?B200系统是一款4U的高密度服务器,专为运行深度学习和大规模计算工作负载而设计。

这种系统能够集成多达八块NVIDIA A100 Tensor Core GPU,每个GPU可以为复杂的计算任务提供强大的并行处理能力。

利用NVIDIA的GPU架构,HGX?B200在处理AI推理、训练和 HPC 工作负载时,都能够提供卓越的性能,其设计本身便是为了最大化数据的吞吐量与处理效率。

在硬件架构方面,HGX?B200采用了最新的第三代NVIDIA NVLink技术,

这一高带宽、低延迟的互连机制使得GPU之间的通信速度大幅提升。通过NVLink的支持,系统内各个GPU之间可以实现高达600 GB/s的带宽,这对于需要处理大量数据的机器学习模型训练至关重要。与此同时,HGX?B200还能够通过NVIDIA的NVSwitch实现多GPU之间的高效流量共享,确保各GPU资源的合理利用,提升整体计算性能。

内存配置方面,HGX?B200提供高达128 GB的GPU内存,每个GPU都能够直接访问这些内存。

这一特性使得系统可以在运行大规模模型时,避免频繁的数据传输,从而降低延迟并提高处理效率。此外,HGX?B200还兼容高速DDR4和DDR5的内存配置,为处理快速增长的计算需求提供了强大的支持。

在网络连接方面,HGX?B200支持100Gb/s以太网和InfiniBand,能够满足大规模数据中心在传输速度和数据吞吐量上的苛刻需求。

尽管在许多高性能计算和深度学习任务中,数据传输的需求往往是性能瓶颈,HGX?B200通过灵活的网络联接方案,确保了数据在各处理器之间的快速流通,从而为实现深度学习和其他计算密集型任务铺平道路。

HGX?B200不仅在硬件性能上表现突出,其软件生态也同样强大。

NVIDIA为HGX?B200提供了一套完整的软件堆栈,包括用于深度学习和高性能计算的CUDA、cuDNN和TensorRT等工具。这些工具不仅使得开发人员能够充分利用GPU的计算能力,还能够简化模型的构建与优化过程。此外,HGX?B200与多种主流的深度学习框架(如TensorFlow、PyTorch等)兼容,使得用户可以轻松地将现有模型迁移到这一平台。

该系统在各类应用领域都展现出极大的潜力。

首先,在人工智能领域,HGX?B200能够加速深度学习模型的训练,特别是在图像识别、自然语言处理和推荐系统等任务中,其强大的并行处理能力使得训练时间显著减少。

其次,在科学计算和模拟领域,HGX?B200可以为物理模拟、化学反应模型以及其他复杂的计算场景提供强有力的支持,推动科学研究的进步。

值得关注的是,HGX?B200的设计还考虑到了能源效率。

相较于传统的计算架构,这一系统能够在提供更高性能的同时,降低功耗。这一特性在如今关注绿色计算的环境中尤为重要,很多数据中心都在寻找方法来提高能效,同时减少运营成本。HGX?B200通过采用先进的散热技术与高效能的冲突管理策略,使得在高负载下依然能保持较低的能耗和温度。

综合来看,NVIDIA HGX?B200 8-GPU系统在性能、灵活性以及能效等方面的多重优势,使其成为高性能计算与人工智能领域的重要选择。这种系统不仅可以支持现有的计算需求,还为未来新兴技术的发展打下了基础。随着AI和大数据的持续发展,HGX?B200所具备的强大算力和高效能,必将推动更多创新的实现与应用的落地,成为助力各行业转型升级的重要动力。

热门点击

热门点击

- InnoSwitch3-AQ开

- 首款晶圆边缘刻蚀设备Primo Halona

- 带控制引脚锂电保护芯片 SC5617E

- MPS电源管理解决方案

- 全新系列全桥/H桥集成电路(I

- AI机器人多元未来发展前景及&

- 传感器、芯片和算力平台、通信模

- DLC-2第二代直接液冷技术&

- Data Center Bui

- Immortalis-G925

推荐技术资料

推荐技术资料

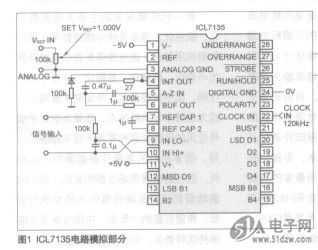

- 自制智能型ICL7135

- 表头使ff11CL7135作为ADC,ICL7135是... [详细]

公网安备44030402000607

公网安备44030402000607